La tecnología nos brinda confort y hace que muchas tareas básicas se hagan de manera automática lo que nos permite emplear nuestro tiempo en otras cosas, pero no todo lo que brilla puede ser oro. Una investigación ha puesto al descubierto una vulnerabilidad que denominaron light commands en los asistentes de voz e incluso en algunos smartphones. Los resultados indican que Alexa, Google Home, Siri, entre otros dispositivos pueden ser hackeados, y la distancia parece no ser un problema. ¿Hasta donde le podemos confiar nuestra seguridad a los asistentes de voz? ¿Sabes como detener una posible incursión no autorizada?

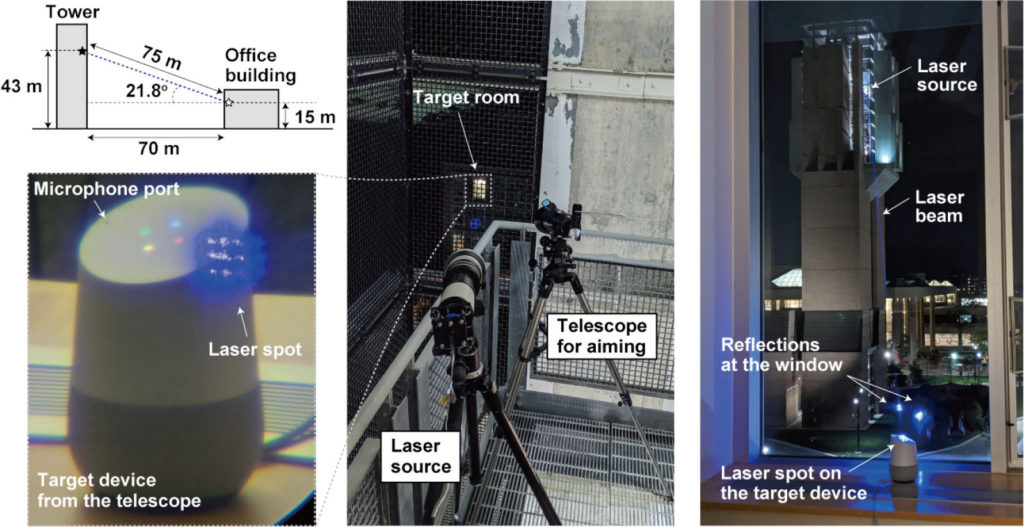

La investigación se llevo a cabo por un equipo de investigadores académicos de la Universidad de Comunicación Electrónica con sede en Tokio y la Universidad de Michigan. El estudio les permitió enviar comandos mediante un laser a distintos dispositivos de reconocimiento de voz y smartphones.

Dentro de los dispositivos que fueron vulnerados por light command son:

- Google Home Google Assistant

- Google Home mini Google Assistant

- Google NEST Cam IQ Google Assistant

- Echo Plus 1st Generation Amazon Alexa

- Echo Plus 2nd Generation Amazon Alexa

- Echo Amazon Alexa

- Echo Dot 2nd Generation Amazon Alexa

- Echo Dot 3rd Generation Amazon Alexa

- Echo Show 5 Amazon Alexa

- Echo Spot Amazon Alexa

- Facebook Portal Mini Alexa + Portal

- Fire Cube TV Amazon Alexa

- EchoBee 4 Amazon Alexa

- iPhone XR Siri

- iPad 6th Gen Siri

- Samsung Galaxy S9 Google Assistant

- Google Pixel 2 Google Assistant

La prueba del light commands se realizó a una distancia de 100 metros, el equipo utilizado fue: un láser, un trípode y un teleobjetivo; el rayo láser incide en el micrófono y este lo interpreta como un sonido que se ajusta a su frecuencia para dictarle una orden, cualquier persona puede acceder a su construcción porque el costo no supera los $600 dólares. De esta manera pudieron transmitir ordenes a los asistentes de voz, todos ejecutaron los comandos sin problema alguno dentro de las funciones que se pueden activar con este hackeo están:

- Controlar los interruptores inteligentes del hogar

- Abrir puertas de garaje inteligentes

- Hacer compras en línea

- Desbloquear y poner en marcha de forma remota ciertos vehículos

- Abre cerraduras inteligentes forzando sigilosamente el número PIN del usuario.

[youtube https://www.youtube.com/watch?v=EtzP-mCwNAs]

Es preocupante esta vulnerabilidad de los asistentes de voz porque cualquier persona puede realizar una incursión en nuestro hogar y no tiene que estar cerca de nuestras casas lo puede hacer desde el otro lado de la calle porque el rayo laser es potente y puede recorrer grandes distancias y para colmo de males es imperceptible.

¿Qué hacer para protegernos de los light commands?

- Sentido común para que los asistentes no expongan su presencia mediante ventanas.

- Colocar el dispositivo asistente de voz disimulando la posición del micrófono.

- Activar una capa de protección de reconocimiento de voz, no es infalible (por los programas de generación de voz, imitan los del usuario) pero retrasa el acceso no autorizado.

Se espera que los fabricantes de los asistentes de reconocimientos de voz tomen cartas en el tema de los light commands y realicen los ajustes necesarios para evitar que sean hackeados.

¿Confías plenamente en los asistentes de voz? ¿Se debería limitar el uso de los asistentes de voz a ciertas funciones?